Por que câmeras serão sempre (opticamente) melhores que smartphones

Na última semana, a Apple lançou uma nova geração de iPhone. Este ano, o iPhone XS adiciona um sensor ligeiramente maior, além de um poder de computação significativamente maior através do A12 Bionic Chip, para melhorar o processamento do sinal de imagem da câmera.

Mas apesar da capacidade de realizar 5 trilhões de operações por segundo, o iPhone ainda não pode fazer algo que uma câmera dedicada pode, captar muita luz. E quando se trata de fotografia, a exposição real (ou seja, o número total de fótons capturados) está diretamente relacionada à qualidade da imagem.

Em artigo para o site DIYPhotography, o fotógrafo Allen Murabayashi, formado pela Universidade de Yale, presidente e co-fundador do blog PhotoShelter, e co-apresentador do podcast “I Love Photography” no iTunes, explica porque câmeras são opticamente melhores que smartphones.

Modo Retrato é apenas uma máscara

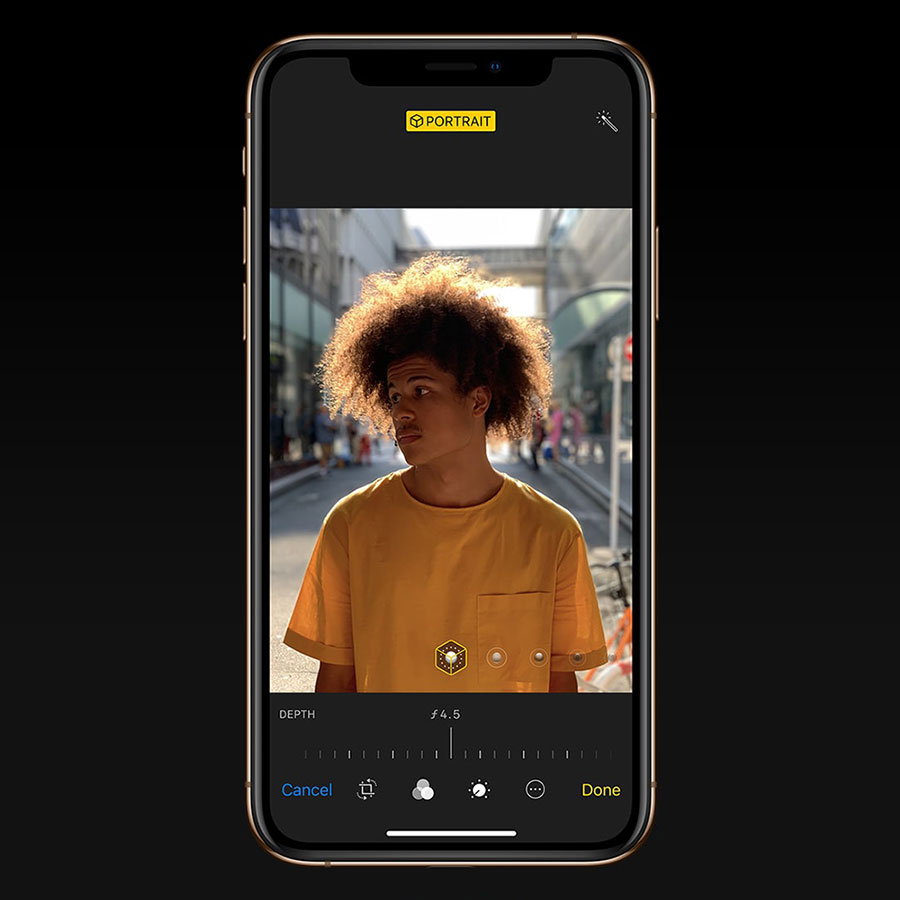

Um dos novos recursos do iPhone é a capacidade de alterar a profundidade de campo da imagem capturada (o modo retrato de primeira geração fornecia apenas uma configuração predeterminada). A interface do usuário emprega um dial f-stop, mas esse é apenas um recurso esqueumórfico que usa uma referência de abertura full frame para correlacionar aproximadamente o grau de profundidade de campo.

A grande maioria dos smartphones tem aberturas fixas, e o tamanho do sensor em relação à distância focal da lente significa que tudo na cena tende a estar nítido. Então, os smartphones criam mapas de profundidade usando duas câmeras (por exemplo, o iPhone) ou um design de subpixel (por exemplo, Pixel2) combinados com uma rede neural para determinar os elementos de primeiro plano e plano de fundo.

Mesmo que o iPhone XS permita alterar a profundidade de campo no pós, não é uma câmera de campo de luz (também conhecida como plenoptic) que capta a intensidade e a direção da luz. O processador do iPhone permite mascarar de forma mais inteligente os elementos de primeiro plano e plano de fundo, ao mesmo tempo em que reconhece características faciais, cabelos, etc. O mostrador de abertura combinado com o processador significa que ele pode aumentar o raio de desfoque de elementos fora da máscara.

O software, sem dúvida, continuará a melhorar, mas você ainda pode encontrar erros que nunca ocorreriam com a captura óptica.

Fotografia computacional ajuda a fazer excelentes imagens, mas…

A fotografia computacional supera as reais limitações de exposição através de vários truques, incluindo empilhamento de imagens e inteligência artificial. O empilhamento de imagens (mais comumente usado para HDR) não apenas preserva os realces e aprimora os detalhes das sombras, mas também pode ser usado como uma estratégia de redução de ruído usando a filtragem mediana.

A inteligência artificial traz uma outra caixa de ferramentas para a fotografia computacional. Embora o uso da inteligência artificial na fotografia computacional ainda seja incipiente, já vimos a prova de conceitos que são impressionantes, como a redução de ruído e a remoção de marca d’água da NVIDIA.

A fotografia computacional poderia, em teoria, combinar várias fotos para obter a foto perfeita de grupo, onde todo mundo está sorrindo (o iPhone usa redes neurais para melhorar a detecção facial). Também poderia teoricamente ter uma única imagem e reconstruir partes da imagem para fazer parecer que todo mundo está sorrindo. Esse tipo de tecnologia apresenta uma consideração ética (especialmente para fotojornalistas), mas também expande dramaticamente as possibilidades criativas.

Quando os fabricantes de câmeras tradicionais vão abranger uma abordagem centrada no software?

Empresas como Nikon, Canon, Sony, Fuji e Hasselblad continuam a desenvolver incríveis sistemas de câmeras, porém, focadas na captura RAW de exposição única na maior parte do tempo. Nesse paradigma, os ajustes de tonalidade e outras manipulações ocorrem fora da câmera. O empilhamento de imagens e panorâmicas devem ser capturados como exposições individuais com acionamento manual do obturador.

Mas para muitos fotógrafos, a velocidade é essencial, e a capacidade de carregar algo semelhante a uma predefinição do Lightroom na câmera ou permitir o empilhamento de imagens na câmera (com redução de ruído instantânea, por exemplo) seria bastante revolucionária. As câmeras independentes continuam sendo dispositivos de hardware dedicados, em vez de máquinas de computação mais flexíveis com recursos de captura de luz.

É difícil imaginar a Apple fazendo um sistema ILP e igualmente difícil imaginar a Nikon/Canon/Sony desenvolvendo softwares de fotografia computacional e chips com recursos de rede neural integrados. Mas imagine as possibilidades…